Hallo ihr Lieben!

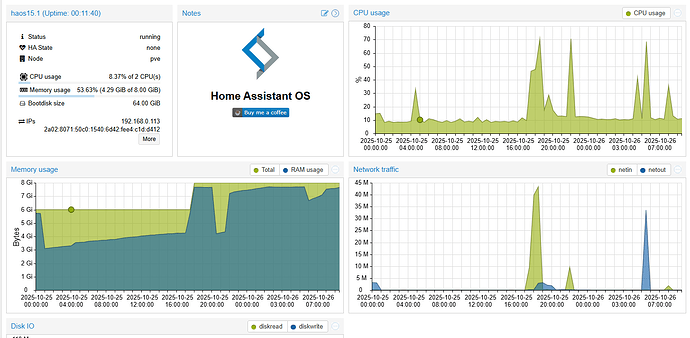

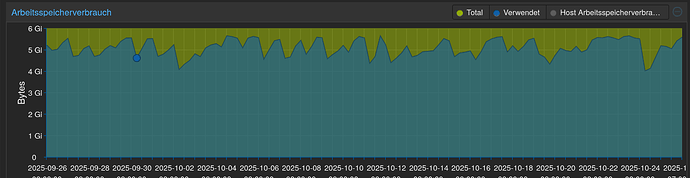

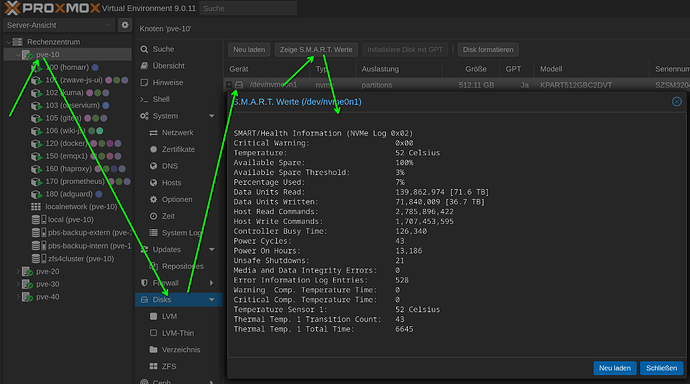

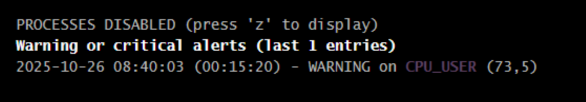

Ich habe seit einigen Tagen ein Problem, welches ich leider nicht mehr gelöst bekomme. Seit einigen Tagen läuft langsam aber konstant der RAM meiner Proxmox VM voll. Leider Gottes hilft weder ein Reboot noch ein Backup-Einspielen um das Problem zu lösen. Hier seht ihr die RAM Kurve in Proxmox:

Bisher hat meine Installation nur so um die 3GB benötigt, ich habe auch leider keinen genauen Zeitpunkt, seit wann das ganze auftritt, sodass ich auch nicht nachvollziehen kann, ob irgend ein Update einer Integration das Problem ist. Wirklich erinnern kann ich mich nur an zwei Automationen, die ich erstellt habe, diese habe ich testweise aber mal deaktiviert, um zu sehen, ob die den RAM volllaufen lassen.

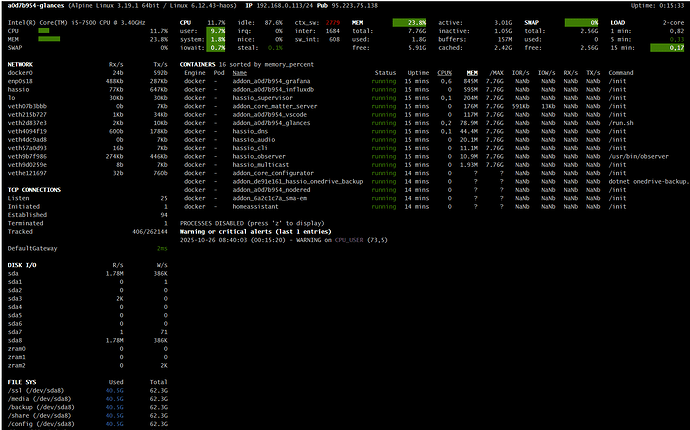

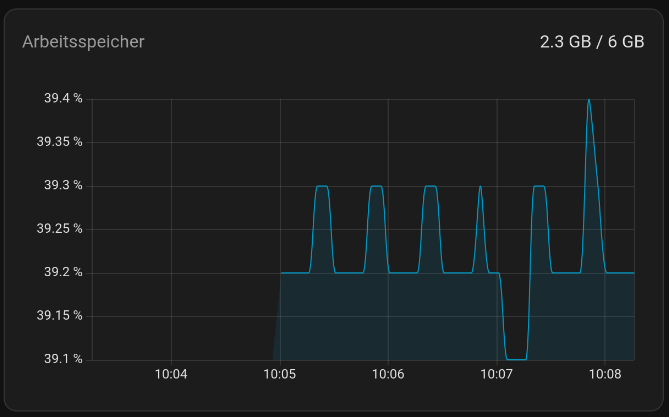

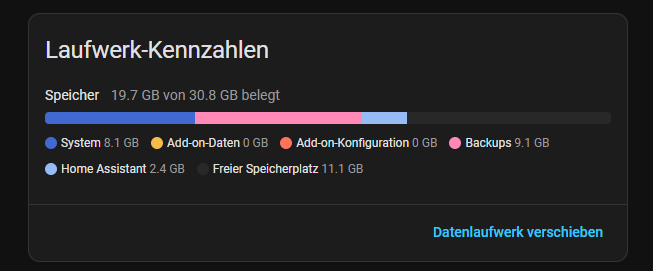

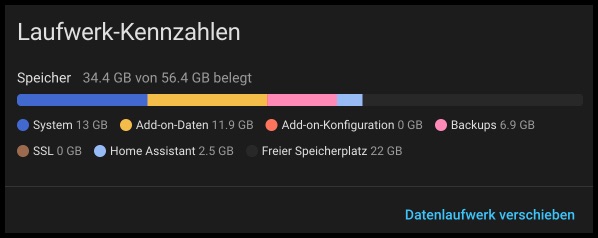

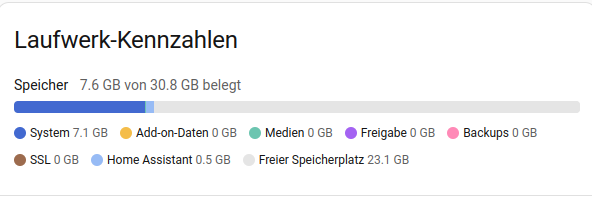

Komischerweise kann ich aber auch eine sehr große Differenz zwischen HA und Proxmox RAM feststellen:

Ich habe wirklich alles versucht: AddOns löschen die ich nicht brauche, Integrationen deaktivieren, LOGS durchforsten (vielleicht aber die falschen?), Backup von letzter Woche einspielen, etc., aber alle Versuche bringen nichts. Hat irgendjemand eine Idee, bevor ich eine neue VM aufsetzte und das Backup mal auf eine neue VM einspiele? Neu Aufsetzten ist leider wirklich keine Möglichkeit, bzw. nur im Absoluten Notfall. Habe extra das Ganze auf Proxmox laufen, weil ich wirklich viel Smarthome habe ![]()

Danke euch im Voraus!

__________________

-

InstallationsmethodeHome Assistant OS

-

Core: 2025.10.4

-

Supervisor: 2025.10.0

-

Operating System: 16.2

-

Frontend: 20251001.4

-

2x CPU, 8GB RAM,