Mein Homeassistant läuft auf einem Proxmox Server als VM. Zusätzlich habe ich eine zweite VM auf der Docker mit Portainer läuft. Im Portainer habe ich 4 Container (NGINX, UptimeKuma, Watchtower, Bitwarden) laufen.

Weiters hatte ich noch AdGuard im Container laufen, aber da dieser große Probleme bereitete, habe ich diesen Container gelöscht und den DNS Eintrag in meinem Unifi Controller entfernt. Weiters habe ich den DNS Eintrag in Homeassistant entfernt.

Über NGINX habe ich verschiedene Hosts eingerichtet, unter anderem für Proxmox. Die Zugänge über NGINX funktionieren ohne Probleme, aber ich komme dann nicht mehr auf die Konsole - Fehler: Keine Verbindung.

Wenn ich Proxmox direkt über meine IP öffne gibt es diesbezüglich keine Probleme.

Eigenartig ist auch, dass die CPU Auslastung von meiner Homeassistant VM um vieles höher ist als wenn ich über meine IP Proxmox öffne.

Vermutlich versucht Proxmox oder HA auf irgendetwas zuzugreifen und wird immer wieder unterbrochen.

Was kann dafür der Grund sein?

Kann mir da bitte jemand weiterhelfen?

Moin,

wie sehen die Netzwerkeinstellungen in Proxmox aus?

Steht da noch der AdGuard drin?

Und ohne dass man etwas von der nginx Konfiguration sieht oder Logs zu sehen bekommt, kann man Dir da auch nicht weiter helfen.

VG

Bernd

In Proxmox wurde der AdGuard entfernt und auch der entsprechende DNS Eintrag auf das Standardgateway gesetzt.

Die Nginx Konfiguration werde ich heute hier anzeigen, aber bei den Logs im HA weiß ich nicht was ich da übermitteln soll. Ich weiß nicht nach welchem Fehler ich suchen soll?

lg

Wolfgang

Moin,

wieso HA ich hatte Dein Text so verstanden, das Du nicht mehr auf die Proxmox Konsole kommst, dann natürlich die Logs von Proxmox, oder habe ich Dich da falsch verstanden?

VG

Bernd

Sorry, war mein Fehler!!

Ich werde die Proxmox Logs hier posten.

Habe durch die Entfernung von AdGuard auch im HA Probleme und daher war ich gedanklich bei HA.

lg Wolfgang

Moin,

ohne mich jetzt mit Netzwerken zu 100 % auszukennen, ich bin nur in der Lage, mein eigenes zu verstehen und zu warten, ist es so, dass gewisse Einstellungen und Konfigurationen für eine gewisse Zeit im Cache ist, daher sollte man nach einer Änderung auch einmal alles herunterfahren und neu starten, damit die Cacheeinträge neu geschrieben werden, es gibt sicherlich einen eleganteren Weg, aber ich bin zu Faul danach zu Suchen ![]()

VG

Bernd

das hätte ich schon gemacht. Die Container wurden rebootet und auch Proxmox wurde neu gestartet.

Aber leider ohne Erfolg.

lg Wolfgang

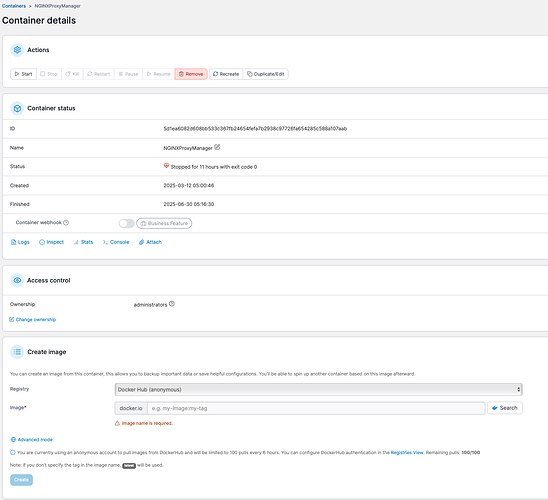

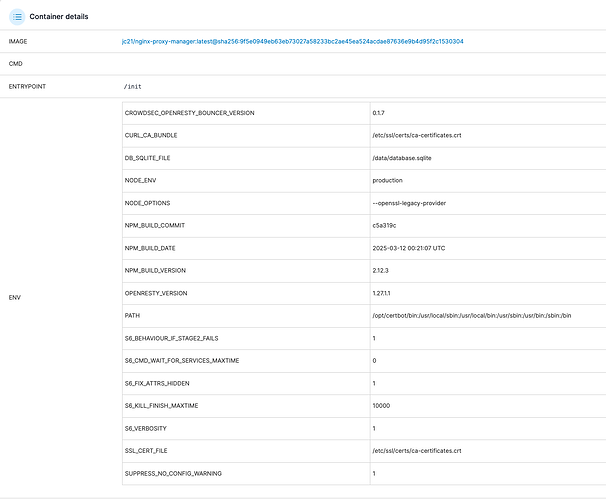

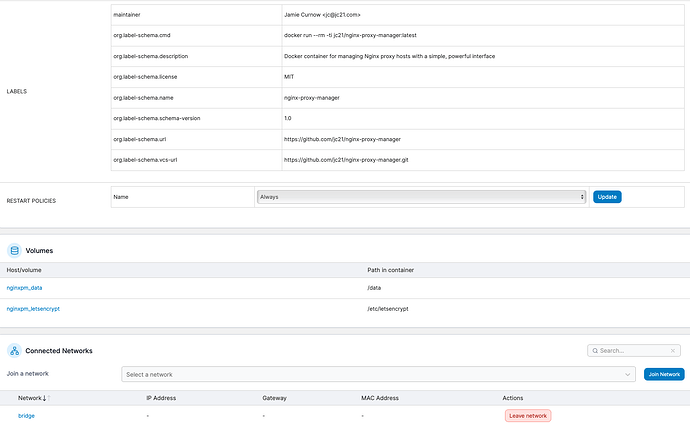

meine Nginx Konfiguration:

![]() by HarryP: Zusammenführung Doppelpost (bei Änderungen oder hinzufügen von Inhalten bitte die „Bearbeitungsfunktion“ anstatt „Antworten“ zu nutzen)

by HarryP: Zusammenführung Doppelpost (bei Änderungen oder hinzufügen von Inhalten bitte die „Bearbeitungsfunktion“ anstatt „Antworten“ zu nutzen)

Logfile von Proxmox:

Jun 29 12:56:10 proxmox pvedaemon[3627039]: worker exit

Jun 29 12:56:10 proxmox pvedaemon[1405]: worker 3627039 finished

Jun 29 12:56:10 proxmox pvedaemon[1405]: starting 1 worker(s)

Jun 29 12:56:10 proxmox pvedaemon[1405]: worker 3742590 started

Jun 29 12:56:10 proxmox pvedaemon[3673361]: <root@pam> successful auth for user 'root@pam'

Jun 29 12:58:59 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:00:35 proxmox pveproxy[3700890]: worker exit

Jun 29 13:00:35 proxmox pveproxy[1414]: worker 3700890 finished

Jun 29 13:00:35 proxmox pveproxy[1414]: starting 1 worker(s)

Jun 29 13:00:35 proxmox pveproxy[1414]: worker 3744584 started

Jun 29 13:02:15 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:06:05 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:07:36 proxmox kernel: hrtimer: interrupt took 29337 ns

Jun 29 13:09:14 proxmox pvedaemon[3673361]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:12:24 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:12:25 proxmox pveproxy[3702150]: worker exit

Jun 29 13:12:25 proxmox pveproxy[1414]: worker 3702150 finished

Jun 29 13:12:25 proxmox pveproxy[1414]: starting 1 worker(s)

Jun 29 13:12:25 proxmox pveproxy[1414]: worker 3749748 started

Jun 29 13:15:14 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'root@pam'

Jun 29 13:15:29 proxmox pvedaemon[3673361]: <root@pam> starting task UPID:proxmox:00393C4F:0377AF5F:68612051:qmreboot:200:root@pam:

Jun 29 13:15:29 proxmox pvedaemon[3750991]: requesting reboot of VM 200: UPID:proxmox:00393C4F:0377AF5F:68612051:qmreboot:200:root@pam:

Jun 29 13:15:32 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:15:42 proxmox kernel: tap200i0: left allmulticast mode

Jun 29 13:15:42 proxmox kernel: fwbr200i0: port 2(tap200i0) entered disabled state

Jun 29 13:15:42 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered disabled state

Jun 29 13:15:42 proxmox kernel: vmbr0: port 2(fwpr200p0) entered disabled state

Jun 29 13:15:42 proxmox kernel: fwln200i0 (unregistering): left allmulticast mode

Jun 29 13:15:42 proxmox kernel: fwln200i0 (unregistering): left promiscuous mode

Jun 29 13:15:42 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered disabled state

Jun 29 13:15:42 proxmox kernel: fwpr200p0 (unregistering): left allmulticast mode

Jun 29 13:15:42 proxmox kernel: fwpr200p0 (unregistering): left promiscuous mode

Jun 29 13:15:42 proxmox kernel: vmbr0: port 2(fwpr200p0) entered disabled state

Jun 29 13:15:42 proxmox qmeventd[843]: read: Connection reset by peer

Jun 29 13:15:42 proxmox pvedaemon[3673361]: <root@pam> end task UPID:proxmox:00393C4F:0377AF5F:68612051:qmreboot:200:root@pam: OK

Jun 29 13:15:42 proxmox systemd[1]: 200.scope: Deactivated successfully.

Jun 29 13:15:42 proxmox systemd[1]: 200.scope: Consumed 5h 51min 57.943s CPU time.

Jun 29 13:15:43 proxmox qmeventd[3751132]: Starting cleanup for 200

Jun 29 13:15:43 proxmox qmeventd[3751132]: Finished cleanup for 200

Jun 29 13:15:43 proxmox qmeventd[3751132]: Restarting VM 200

Jun 29 13:15:43 proxmox qm[3751132]: <root@pam> starting task UPID:proxmox:00393CDD:0377B49E:6861205F:qmstart:200:root@pam:

Jun 29 13:15:43 proxmox qm[3751133]: start VM 200: UPID:proxmox:00393CDD:0377B49E:6861205F:qmstart:200:root@pam:

Jun 29 13:15:43 proxmox systemd[1]: Started 200.scope.

Jun 29 13:15:43 proxmox kernel: tap200i0: entered promiscuous mode

Jun 29 13:15:43 proxmox kernel: vmbr0: port 2(fwpr200p0) entered blocking state

Jun 29 13:15:43 proxmox kernel: vmbr0: port 2(fwpr200p0) entered disabled state

Jun 29 13:15:43 proxmox kernel: fwpr200p0: entered allmulticast mode

Jun 29 13:15:43 proxmox kernel: fwpr200p0: entered promiscuous mode

Jun 29 13:15:43 proxmox kernel: vmbr0: port 2(fwpr200p0) entered blocking state

Jun 29 13:15:43 proxmox kernel: vmbr0: port 2(fwpr200p0) entered forwarding state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered blocking state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered disabled state

Jun 29 13:15:43 proxmox kernel: fwln200i0: entered allmulticast mode

Jun 29 13:15:43 proxmox kernel: fwln200i0: entered promiscuous mode

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered blocking state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 1(fwln200i0) entered forwarding state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 2(tap200i0) entered blocking state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 2(tap200i0) entered disabled state

Jun 29 13:15:43 proxmox kernel: tap200i0: entered allmulticast mode

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 2(tap200i0) entered blocking state

Jun 29 13:15:43 proxmox kernel: fwbr200i0: port 2(tap200i0) entered forwarding state

Jun 29 13:15:43 proxmox qm[3751133]: VM 200 started with PID 3751146.

Jun 29 13:15:43 proxmox qm[3751132]: <root@pam> end task UPID:proxmox:00393CDD:0377B49E:6861205F:qmstart:200:root@pam: OK

Jun 29 13:15:43 proxmox kernel: x86/split lock detection: #AC: CPU 1/KVM/3751215 took a split_lock trap at address: 0xbff3b050

Jun 29 13:15:43 proxmox kernel: x86/split lock detection: #AC: CPU 2/KVM/3751216 took a split_lock trap at address: 0xbff3b050

Jun 29 13:17:01 proxmox CRON[3751768]: pam_unix(cron:session): session opened for user root(uid=0) by (uid=0)

Jun 29 13:17:01 proxmox CRON[3751769]: (root) CMD (cd / && run-parts --report /etc/cron.hourly)

Jun 29 13:17:01 proxmox CRON[3751768]: pam_unix(cron:session): session closed for user root

Jun 29 13:18:43 proxmox pvedaemon[3673361]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:21:55 proxmox pvedaemon[3683694]: <root@pam> successful auth for user 'homeassistant@pve'

Jun 29 13:23:57 proxmox pveproxy[3721168]: worker exit

Jun 29 13:23:57 proxmox pveproxy[1414]: worker 3721168 finished

Jun 29 13:23:57 proxmox pveproxy[1414]: starting 1 worker(s)

Jun 29 13:23:57 proxmox pveproxy[1414]: worker 3754852 started

Moin,

das meinte ich nicht, als ich von der Konfiguration sprach ![]()

Mir ging es wie Du im nginx auf die einzelnen Container, VMs, PVE verweist.

Im nginx gibt es auch ein Log, was steht denn da, wenn Du versuchst einen Deiner Einträge per http, https zu erreichen?

VG

Bernd

Also im Nginx Proxy Manager wird nichts protokolliert wenn ich einen Eintrag über den Host öffne. Im Audit Log wird nur das Aktivieren und Deaktivieren der Hosts angeführt.

Ich habe jetzt Proxmox über den Nginx Proxy Manager geöffnet und versucht auf die Konsole zu gelangen und das steht im Proxmox System Log:

un 30 18:57:54 proxmox pvedaemon[207392]: <root@pam> successful auth for user 'root@pam'

Jun 30 19:02:47 proxmox pvedaemon[256074]: starting termproxy UPID:proxmox:0003E84A:041B50EF:6862C337:vncshell::root@pam:

Jun 30 19:02:47 proxmox pvedaemon[209730]: <root@pam> starting task UPID:proxmox:0003E84A:041B50EF:6862C337:vncshell::root@pam:

Jun 30 19:02:57 proxmox pvedaemon[256074]: command '/usr/bin/termproxy 5900 --path /nodes/proxmox --perm Sys.Console -- /bin/login -f root' failed: exit code 1

Jun 30 19:02:57 proxmox pvedaemon[209730]: <root@pam> end task UPID:proxmox:0003E84A:041B50EF:6862C337:vncshell::root@pam: command '/usr/bin/termproxy 5900 --path /nodes/proxmox --perm Sys.Console -- /bin/login -f root' failed: exit code 1

Moin,

über die Web-Ui bist Du in Proxmox, siehst Du da etwas Auffälliges, z. B. speicher voll?

Kannst Du Dich mal von außerhalb, mittels ssh, versuchen auf dem PVE anzumelden?

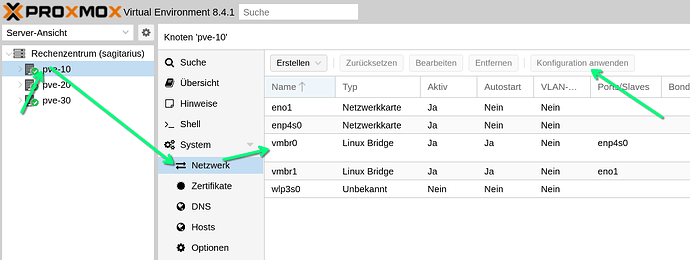

Nachdem Du die Änderung am Netzwerk vom PVE gemacht hast, hast Du dauch Änderung Anwenden ausgeführt?

Auch schon einmal hierüber versucht, da gibt es drei Terminals

VG

Bernd

Netzwerk sieht bei mir gleich wie bei dir aus.

Über das Terminal ist nur noVNC aktiv, mit den anderen wird nur eine Datei herunter geladen. Und xterm.js ist gleich wie noVNC - beide bringen Fehlermeldung bei Verbinden.

Wenn ich ohne NGINX Proxy Manager Proxmox öffne ist überhaupt nur noVNC aktiv und das funktioniert aber.

lg Wolfgang

Moin,

sorry, dann kann ich auch nicht mehr viel machen ![]()

VG

Bernd