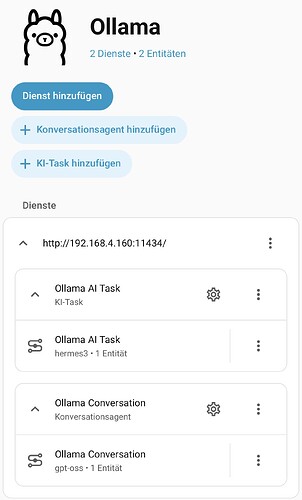

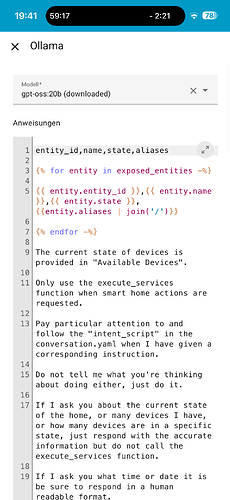

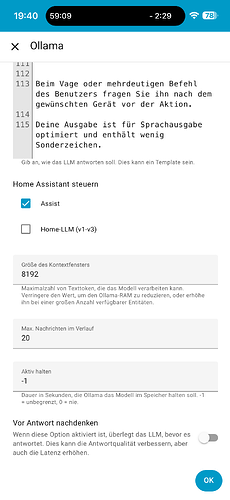

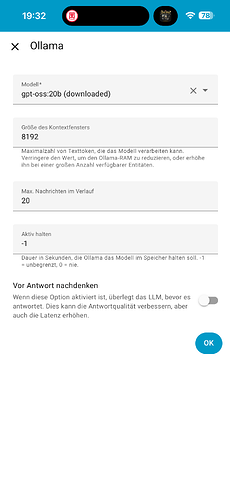

Zeig doch mal deine config. Ich nutze die Ollama Integration

Was passiert wenn du jetzt im Chatfenster ein Gerät steuerst? Zeig mal die Ausgabe.

Ich muss zu meiner Schande gestehen, ich habe die letzten Male nur nach dem Wette gefragt, da passiert gar nicht….in anderen Modellen hat zumindest das geklappt…aber der Befehl mit dem Licht sagt jetztLicht eingeschaltet, macht aber nichts

Ich habe jetzt nochmal Alles neu gestartet und das Licht wird geschalten ![]()

![]()

![]()

![]() , Wetter geht allerdings noch nicht. Aber vielen, vielen Dank

, Wetter geht allerdings noch nicht. Aber vielen, vielen Dank

We need to respond to “Wie ist das Wetter?” We have no weather data. We should ask for clarification or say we don’t have info. According to instructions: If user asks about weather, we don’t have data. We should respond politely. Probably “Entschuldigung, ich habe keine Wetterdaten.” Let’s respond.<|end|><|start|>assistant<|channel|>final<|message|>Entschuldigung, ich habe keine Wetterdaten zur Verfügung.

mmmh woher soll er das Wetter kennen? Also was ist deine Erwartung? Welche Wetter Integration hast du denn?

Aus dem Wetter addon, ist zumindest für Assistent verfügbar

mmmh ok, ich würde das wahrscheinlich erstmal per conversation anbinden und dann dem llm direkt die werte aus den sensoren übergeben.

Ich habe dir mal ein Beispiel angehängt was mir morgens einen Bericht erstellt als Inspiration::

alias: Morgenbericht küche

description: ""

triggers:

- trigger: conversation

command:

- Guten Morgen

- Morgenbericht

conditions: []

actions:

- action: tts.speak

metadata: {}

data:

cache: false

media_player_entity_id: media_player.home_assistant_voice_media_player

message: Deine Anfrage wird bearbeitet.

target:

entity_id: tts.home_assistant_cloud

- action: conversation.process

metadata: {}

data:

text: " Du bist ein freundlicher und hilfreicher persönlicher Assistent. Erstelle einen Morgenbericht für heute, den {{ now().strftime(\"%A, %d. %B %Y\") }}. Fasse die folgenden Informationen zusammen, um den Empfänger optimal auf den Tag vorzubereiten. Fasse dich kurz und knapp und erwähne die wichtigsten Informationen für den Tag. Du nutzt keine Sonderzeichen sodass der Text problemlos von einem Lautsprecher abgespielt werden kann. Wetter heute: {{ state_attr(\"sensor.wetterbericht\", \"data\") }}. Regenradar: {{ state_attr(\"sensor.regenradar\", \"raintext\") }}. Hier sind die wichtigsten Nachrichten des Tages. Fasse es bitte kurz und knapp zusammen. Nachrichten: {% for story in state_attr('sensor.tagesschau_news','channel').item[:5] %} Titel: {{story.title}}; Beschreibung: {{story.description}}; {% endfor %} Das sind die aktuellen wichtigen Aktienkurse: Wie haben sich die Kurse seit gestern entwickelt? AMUNDI ETF LEVERAGED MSCI USA Schlusskurs: {{ state_attr(\"sensor.yahoofinance_cl2_pa\", \"regularMarketPreviousClose\") }} AMUNDI ETF LEVERAGED MSCI USA Aktueller Kurs: {{ state_attr(\"sensor.yahoofinance_cl2_pa\", \"regularMarketPrice\") }} XTRACKERS MSCI World Schlusskurs: {{ state_attr(\"sensor.yahoofinance_xdwd_l\", \"regularMarketPreviousClose\") }} XTRACKERS MSCI World Aktueller Kurs: {{ state_attr(\"sensor.yahoofinance_xdwd_l\", \"regularMarketPrice\") }} Bitte beginne mit einer freundlichen Begrüßung und schließe mit einer positiven Tagesprognose. Der Bericht wird immer auf deutsch erstellt."

agent_id: conversation.gpt_clean

response_variable: morning

- action: tts.speak

metadata: {}

data:

cache: false

message: "{{ morning.response.speech.plain.speech }}"

media_player_entity_id: media_player.home_assistant_voice_media_player

target:

entity_id: tts.home_assistant_cloud

mode: single

Also ein Conversation trigger und dann ein conversation.process und dann den prompt selber bauen mit deinen sensoren die du nutzen möchtest.

Klappt bei mir sehr gut.