OK, danke!

Ich wundere mich nur, weil ich das irgendwann auch mal auf Standard hatte. Hab ich dann aber in der Historie Daten weit hinten in der Vergangenheit gesucht (> 10 tage), dann war da nichts mehr vorhanden. Theoretisch müsste es aber doch vorhanden sein, da er das ja auch der Langzeittabelle dann holt, wenn ich es richtig verstanden habe. Oder?

Moin,

werde mal konkret!

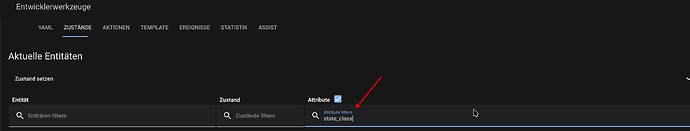

Alle Entitäten, die ein unit_of_measurement und satate_class: haben, kommen automatisch in die Statistiktabellen, alles andere wird nach 10 Tagen gelöscht.

VG

Bernd

Ah, verstehe. Sorry, dass wusst ich nicht.

Also muss ich nur diese beiden Attribute mit egal welchem Inhalt bei Sensoren definieren und dann werden sie in der Langzeittabelle gespeichert, richtig?

Danke schön!

Moin,

Du musst Dich nicht entschuldigen, ich verstehe auch nicht alles und muss öfter durch Versuchen herausfinden wie es funktioniert, außerdem bauen wir ja so unsere Wissensdatenbank auf ![]()

Nein, das muss schon passen, sonst wird das nichts.

Wetterdaten sollten ja diese Attribute haben oder sind das bei Dir eigene?

Habe gerade noch mal geschaut, bei mir sind alle Entitäten, die ein Attribut state_class haben, auch in den Statistiktabellen (Langzeitdaten) enthalten, bei dem Attribut unit_of_measurement nur einige, die haben dann aber auch state_class.

Siehst Du ja hier

VG

Bernd

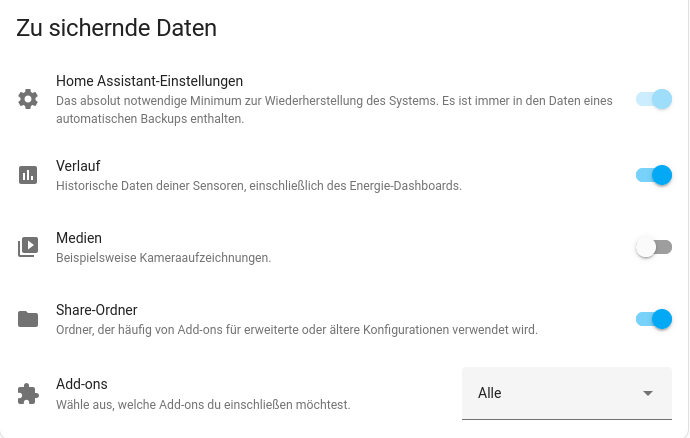

Wenn das wirklich zutreffen sollte, würde das bedeuten das Du seit Sep. letzten Jahres auch keinerlei HA Updates installiert hast. Was ich mir nicht wirklich vorstellen kann. ![]() Falls dem wirklich so ist und seit Sep. letzten Jahres weder weitere Geräte hinzugekommen sind, noch Du irgendwelche zusätzlichen Sensoren in der Datenbank Daten erfassen lässt, dann kann sich die Backup-Größe seit Anfang des Jahres nur dadurch mehr als verdoppelt haben in dem Du z.B. irgendwelche Dinge unter HA speicherst, oder speichern lässt. Z.B. irgendwelche Kamera-Aufnahmen, oder Du hast ggf. irgendwelche Medien hochgeladen.

Falls dem wirklich so ist und seit Sep. letzten Jahres weder weitere Geräte hinzugekommen sind, noch Du irgendwelche zusätzlichen Sensoren in der Datenbank Daten erfassen lässt, dann kann sich die Backup-Größe seit Anfang des Jahres nur dadurch mehr als verdoppelt haben in dem Du z.B. irgendwelche Dinge unter HA speicherst, oder speichern lässt. Z.B. irgendwelche Kamera-Aufnahmen, oder Du hast ggf. irgendwelche Medien hochgeladen.

PS: Eine Backup-Größe von unter 1GB ist nicht wirklich viel. Hier gibt es User die haben da 30, 50 oder sogar noch mehr GB große Backups. ![]()

VG Jim

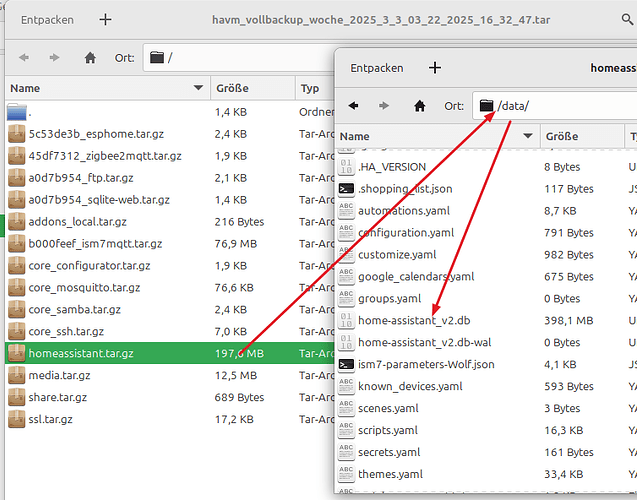

Entpacken und ansehen…

Erstmal ist es ja Dein Backup, das so groß ist. Dies kannst Du entpacken und dann vergleichen, was so viel mehr Platz einnimmt.

Da ![]()

Wie @tarag bereits geschrieben hat: Einfach die *.tar-Dateien von den Backups entpacken und die Inhalte vergleichen. Dann solltest Du sehen können ob nicht vielleicht doch in den letzten Monaten ein zusätzliches Addon hinzugekommen ist, ob es ggf. zusätzliche Dateien in dem Media-Ordner gibt, ob die HA DB-Datei ggf. stark angewachsen ist, usw. 7-zip zum entpacken der *.tar Dateien hast Du auf der Kiste mit der Du den Screenshot erstellt ja bereits installiert.

Was ich zwar nicht glaube, aber was theoretisch natürlich auch noch möglich ist, das Du ggf. nach dem Backup vom 02.03.2025 irgendeine Änderung bei den Backup-Einstellungen vorgenommen hast,

sodass bei dem Backup am 17.03.2025 mehr gesichert wurde als vorher. Aber auch das solltest Du bei dem Vergleich der Backups eigentlich erkennen können.

VG Jim

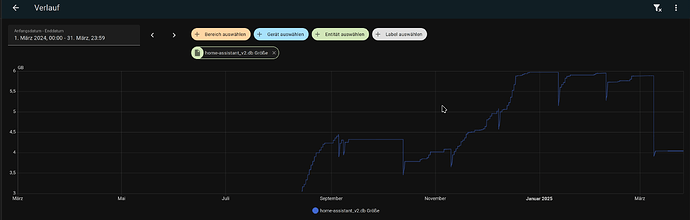

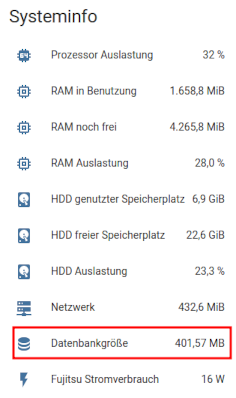

Wie Du ja sehen kannst hat sich die DB-Größte innerhalb von 21 Tagen fast verdoppelt und das kann eigentlich nur dadurch passieren das in der DB jetzt mehr Daten von Sensoren/Entitäten gespeichert werden als vorher.

Mir ist auch nicht bekannt das es in den letzten 1 - 2 Monaten HA Core Updates gab, bei denen es für die DB, oder bei der Art wie oder welche Daten dort gespeichert werden, irgendwelche Änderungen gab die so ein Verhalten erklären ließen. Daher gehe ich eher davon aus das bei Dir ggf. doch irgendwelche Geräte hinzugekommen sind, oder es irgendwelche anderen (manuellen) Veränderungen gab, die dafür gesorgt haben das jetzt mehr Daten in der DB erfasst werden. Das kann z.B. auch durch irgendein Update hervorgerufen worden sein, weil nach dem Update bei einem Gerät z.B. mehr Sensoren/Entitäten zur Verfügung standen, oder irgendwelche Sensoren/Entitäten in kürzeren Abständen Daten an die DB senden, oder oder oder.

Was jetzt genau dafür die Ursache ist könnte man wohl nur herausbekommen wenn man die alte und neuere DB Datei analysiert, aber das ist ein Aufwand den wohl kaum jemand machen würde. Ich jedenfalls in dem Fall nicht. Ich würde das erst einmal stumpf aussitzen und abwarten wie sich das weiter entwickelt und das ist ja auch Dein Plan. ![]()

Spätestens nach dem nächsten, automatischen purge nach 30 Tagen sollte sich die DB-Größe auf jeden Fall wieder verringern, bzw. verringert haben.

VG Jim

Moin,

das ist doch Pipifax, selbst 700 MB ist ja noch lächerlich ![]()

Dein System läuft standardmäßig mit der SQLite Datenbank, es werden da alle möglichen Dinge, im Standard für 10 Tage gehalten und Langzeitdaten dann für immer, also wird Deine Datenbank auch anwachsen, weil sich Langzeitdatendaten ansammeln werden!

Wenn sich Sprünge ergeben, dann liegt das an nicht ausgeführten Aufräumaktionen, oder durch Updates neue Daten dazugekommen sind, auch jedes Event, wird in der Datenbank für 10 Tage gespeichert, also jede Aktion, Licht an, Licht aus, oder verrücktspielende Geräte, die sich ständig an und abmelden, also Du siehst, das System wird sich nie statisch verhalten, es wird sich irgendwann mal einpendeln aber nie bei einer größe x verharren.

Mit welchen Ressourcen betreibst Du dein HA, wenn ich bei mir schaue, dann ist meine SQLite Datebank im Mittel 4 GB groß, und schwankt immer so um die 3,5 - 4, 8 GB.

VG

Bernd

P.S.: Mein HA ist jetzt, ~ 15 Monate im Betrieb und ich musste noch nie ein Backup zurückspielen, es sind also alles echte Daten aus dem Zeitraum, ich habe auch an den Einstellungen, zum Recorder nichts verstellt.

Servus,

hast du schon mal geschaut, welche Entitäten da den meisten Platz belegen?

z.B. so in SQLite Web:

SELECT

COUNT(*) AS cnt,

COUNT(*) * 100 / (SELECT COUNT(*) FROM states) AS cnt_pct,

states_meta.entity_id

FROM states

INNER JOIN states_meta ON states.metadata_id=states_meta.metadata_id

GROUP BY states_meta.entity_id

ORDER BY cnt DESC

Gruß

Rudi

Das ist aber “viel”. ![]() Meine DB ist aktuell nur noch 400 MB groß.

Meine DB ist aktuell nur noch 400 MB groß.

Die habe ich “zurechtgeschrumpft”, weil mein HA dann gleich viel schneller ist. ![]()

Ne ist natürlich nur Spaß. ![]() Das komische Verhalten was die DB vor Monaten mal an den Tag gelegt hat und was hier in dem Beitrag und auch in anderen Beiträgen hier im Forum mal Thema war, lag ja an Änderungen oder z.T. an temporären Bugs bei HA, die mit Updates dann auch wieder aus der Welt geschafft wurden. Aktuell sind zumndest mir bzgl. der HA DB keinerlei Probleme oder Bugs bekannt und falls es bei jemanden wirklich mal prozentual gesehen einen starken Größenanstieg der DB geben sollte, dann dürfte das an der individuellen Einrichtung und Konfiguration von HA liegen, oder halt an einer Integration oder einem Addon, die oder das da ggf. Mist baut. Was man dann machen könnte ist hier in dem Beitrag ja bereits im letzten Jahr alles schon mal erwähnt worden.

Das komische Verhalten was die DB vor Monaten mal an den Tag gelegt hat und was hier in dem Beitrag und auch in anderen Beiträgen hier im Forum mal Thema war, lag ja an Änderungen oder z.T. an temporären Bugs bei HA, die mit Updates dann auch wieder aus der Welt geschafft wurden. Aktuell sind zumndest mir bzgl. der HA DB keinerlei Probleme oder Bugs bekannt und falls es bei jemanden wirklich mal prozentual gesehen einen starken Größenanstieg der DB geben sollte, dann dürfte das an der individuellen Einrichtung und Konfiguration von HA liegen, oder halt an einer Integration oder einem Addon, die oder das da ggf. Mist baut. Was man dann machen könnte ist hier in dem Beitrag ja bereits im letzten Jahr alles schon mal erwähnt worden.

VG Jim

Moin,

ja, ich habe aufgehört, mir einen Kopf darum zu machen, wie HA da seine Daten verwaltet ![]()

Wenn ich mir den Verlauf mal anschaue, seit ich die Dateigröße als Sensor betrachte, dann habe ich immer nur ? in den Augen ![]()

Solange das nicht in die TB geht, ist mir das eigentlich egal, ~ 4 GB ist für mich vollkommen OK, selbst im zukünftigen System, das nur als LXC ohne irgendein Add-on läuft, aber schon alle Entitäten hat, ist das SQLite Datenbankfile ~ 3,5 GB groß, somit gehe ich davon aus, dass das für meine Installation passt, ohne jetzt eine Entscheidung für, oder gegen eine einzelne Entität zu treffen, einfach ausgedrückt, der Standard macht für mich das was er soll ![]()

VG

Bernd

Jepp diese teils unterschiedlich starken Purge-Bereinigungen nach den 30 Tagen versuche ich mir auch erst gar nicht mehr zu erklären. ![]() Bei Dir sieht man im März ja auch einen Purge, der wohl der übliche nach 30 Tagen war und bei dem plötzlich die DB-Größe um 1/3 und rund 2 GB verringert wurde. Ähnlich war es bei mit Anfang Februar, sprich da hat der 30-Tage-Purge meine DB von 1.200 MB auf 300 MB reduziert und eine wirkliche Erklärung dafür konnte ich auch nicht finden.

Bei Dir sieht man im März ja auch einen Purge, der wohl der übliche nach 30 Tagen war und bei dem plötzlich die DB-Größe um 1/3 und rund 2 GB verringert wurde. Ähnlich war es bei mit Anfang Februar, sprich da hat der 30-Tage-Purge meine DB von 1.200 MB auf 300 MB reduziert und eine wirkliche Erklärung dafür konnte ich auch nicht finden.

—> Einfach ggf. zur Kenntnis nehmen und ansonsten einfach ignorieren. ![]()

Nur falls ein Sensor mal aus der Reihe tanzen sollte, oder von Haus aus bereits unnötig DB-Einträge macht, könnte/sollte/müsste man ggf. eingreifen. ![]()

Ein Sensor von meiner Wolf Heizung wäre da ein Beispiel, der tatsächlich jede Sekunde, eben weil sich die Uhrzeit halt jede Sekunden geändert hat, einen Eintrag in de DB vorgenommen hat. Der Sensor hat dann schnell den Spitzenplatz in der SQLite DB eingenommen, was die Häufigkeit der Einträge dort betrifft. ![]() Also für mich ein klassischer Kandidat dafür:

Also für mich ein klassischer Kandidat dafür:

logbook:

exclude:

entities:

- sensor.wolf_bm2_0x30_uhrzeit

recorder:

exclude:

entities:

- sensor.wolf_bm2_0x30_uhrzeit

VG Jim