Hallo,

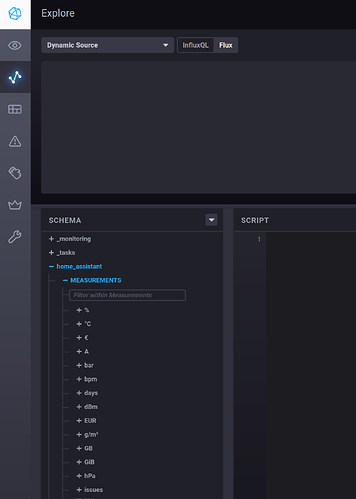

Ich teste gerade die Möglichkeiten von HA um ggf von einer Iobroker Installation umzusteigen. Aktuell ist die Influxdb Integration an der Reihe. HA läuft auf einer Synology VM und Influxdb auf einem Raspi4.

Ich habe versucht die Influxdb Integration zu installieren, bekommen aber die Meldung, dass das über die Benutzeroberfläche nicht geht, sondern über Einträge in der configuration.yaml. Dort habe ich dann folgende Einträge hinterlegt:

influxdb:

host: ip der influxdb installation

port: port der influxdb installation

database: iobroker

username: juergen

password: mein_pw

ssl: false

verify_ssl: false

max_retries: 3

default_measurement: state

include: !include include_influxdb.yaml

In der include_influxdb.yaml datei habe ich dann eine Entität hinterlegt, die ich übertragen will:

entities:

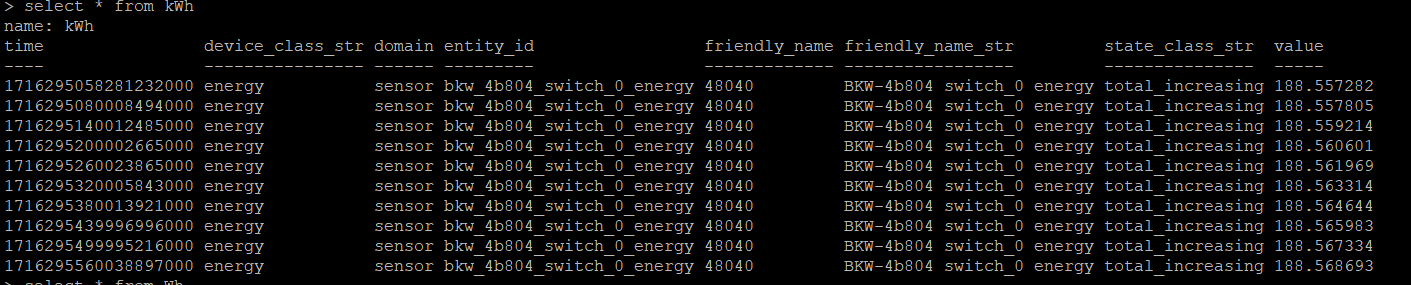

- sensor.bkw_4b804_switch_0_energy

HA neu gestartet, keine Fehlermeldung im Log, aber auch kein Wert in der Influxdb.

Habe ich etwas übersehen, vergessen? Was muss ich tun?

Vielen Dank schon mal für eure Hilfe.

Jürgen